Model hırsızlığı ve çıkarım saldırıları en önemli endişeler arasında yer alıyor

Üretken yapay zeka, potansiyeli nedeniyle müjdelenen ancak aynı zamanda sonuçları açısından da incelenen güçlü bir araç olarak ortaya çıktı. İşletmeler dünya çapında yaklaşık 16 milyar dolar yatırım yapacak GenAI IDC’ye göre 2023’te.

Bu Help Net Security röportajında, CEO Guy Guzner şirket içi yapay zeka modellerinin sunduğu zorlukları ve fırsatları, bunları çevreleyen güvenlik ortamını ve yapay zeka siber güvenliğinin geleceğini tartışıyor.

Üretken yapay zeka, BT liderlerinin yararlarından emin olmasına rağmen endişeleri artırıyor. Kuruluşların yapay zeka modellerini henüz olmasa bile yakın zamanda şirket içinde oluşturmaya başlamasının beklendiği göz önüne alındığında, akılda tutmaları gereken acil güvenlik hususları nelerdir?

Şirket içi yapay zeka modelleri geliştiren kuruluşlar, kritik güvenlik sorunları söz konusu olduğunda belirgin bir avantaja sahiptir. Şu anda yaygın olarak benimsenen üretken yapay zeka ve diğer SaaS uygulamaları, entegrasyon karmaşıklıkları nedeniyle güvenlik protokollerinin standartlaştırılmasında zorluklara yol açarak BT ile iş birimleri arasında sürtüşmeye neden oldu. Şirket içi yapay zeka modellerinin geliştirilmesi, bu üçüncü taraf çözümlerin popülerliğinden kaynaklanan SaaS artışlarının bir kısmının bastırılmasına yardımcı oluyor.

Ancak kuruluşların dikkate alması gereken önemli bir husus, yapay zeka modellerinde kullanılan algoritmaların güvenliğidir. Üretken yapay zeka, yeni veriler oluşturmak için algoritmaları ve eğitim verilerini kullanır. Şirket içi bir yapay zeka çözümü planlarken ve oluştururken her iki unsuru da parçalara ayırmak ve parçalara özgü güvenlik risklerini değerlendirmek önemlidir.

Eğitim verileri sonuçta model tarafından oluşturulan içeriği etkiler. Eğitim verilerindeki önyargılar ve riskler, modellerin çıktılarında kendini gösterecek ve henüz tam olarak anlamadığımız kalıcı sonuçlara neden olacaktır. Bu nedenle kuruluşların potansiyel önyargıları ve riskleri belirlemek ve azaltmak için eğitim verilerini titizlikle değerlendirmesi gerekir.

Yapay zekanın riskleri dikkate alınırken fikri mülkiyet kaygıları ve düzenleyici uygulamalar vurgulanmıştır. Sizce kuruluşlar yapay zekanın gücünden yararlanma ile bu endişeleri azaltma arasında nasıl bir denge kurabilir?

Her şeyden önce, açık etik kurallar oluşturmalısınız. Yapay zeka uygulamalarına ilişkin şeffaflık ve açık iletişim, paydaşlar arasında güveni artırarak sorumlu yapay zeka kullanımı için bir temel sağlar. Şirketler, veri kaynaklarını açıkça etiketlemeli ve verilerle ilgili gizlilik ve kabul edilebilir kullanım politikalarına saygı göstermeli, etik kullanımı sağlamalı ve fikri mülkiyet endişelerini azaltmalıdır.

İşbirliği de çok önemli bir rol oynuyor. Kuruluşlar, en iyi uygulamaları ve standartları oluşturmak için emsalleri ve düzenleyici kurumlarla yakın çalışmaktan yararlanır. İçgörülerin paylaşılması Yapay zeka riskleri ve azaltma stratejileri, tehditlere karşı kolektif savunmayı güçlendirerek daha güvenli bir yapay zeka ortamı yaratır.

Bu arada şirketler, hassas veri girişinden korktukları için üçüncü taraf genAI uygulamalarını hızla engelliyor, ancak kullanıcılar muhtemelen bilgileri çalışmayan bir cihazdan giriyorlar. ChatGPT gibi uygulamaların cazibesi, tüm çalışanların kısıtlayıcı yönergelere uymasını beklemek için fazla büyük; dolayısıyla bunun yerine güvenli kullanımı teşvik etmeleri gerekiyor.

Kuruluşlar, kullanıcı farkındalığını artırmak, kullanıcıları potansiyel riskler konusunda uyarmak ve onları engellemek yerine güvenli uygulamalara yönlendirmek için tasarlanmış araçlardan yararlanmalıdır. Örneğin, araçların hassas veriler tespit etmesi durumunda kullanıcılardan ChatGPT’de özel modu açmak veya istemden belirli kelime ve ifadeleri kaldırmak gibi gerekli önlemleri almaları istenmelidir.

Tehditlerin gelişen doğası göz önüne alındığında, kuruluşların yapay zeka modellerini güvence altına alma konusunda reaktif olmaktan ziyade proaktif olmaları ne kadar önemli?

Kuruluşların, genAI SaaS’ın hızla benimsenmesinin, standartlaştırılmış uygulamaların eksikliğinin ve uygulama entegrasyonlarının getirdiği karmaşıklıkların yarattığı zorluklardan ders alması gerekiyor. Dizginsiz SaaS yayılımı, kaynak sıkıntısı çeken kuruluşları geniş ölçekte etkili güvenlik kontrolleri uygulamaya zorladı.

Kuruluşlar proaktif güvenliği benimseyerek potansiyel riskleri öngörebilir, savunmalarını güçlendirebilir ve ihlalleri önleyebilir. Bu sadece güvenlik açıklarını düzeltmekle ilgili değil, daha ziyade potansiyel güvenlik açıklarını tahmin etmek ve bunlara karşı önlem almak için proaktif önlemler uygulamakla ilgili. Bunu yaparak kuruluşlar yalnızca yapay zeka modellerini korumakla kalmayacak, aynı zamanda inovasyon ve büyüme ortamını da teşvik ederek dijital varlıklarının SaaS’ın yayılması ve diğer siber güvenlik tehditlerinin yarattığı zorluklara karşı korunduğu bilgisini güvence altına alacak.

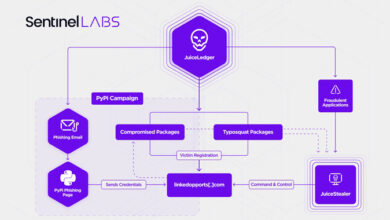

Model hırsızlığı, çıkarım saldırıları ve veri zehirlenmesi, analistler tarafından vurgulanan yapay zeka modellerine yönelik potansiyel saldırılardan bazılarıdır. Listelenen saldırılardan hangileri en tehdit edici veya potansiyel olarak zarar verici olanıdır ve neden?

Vurgulananlardan saldırılar, model hırsızlığı ve çıkarım saldırıları özellikle tehditkardır. Model hırsızlığı, kötü niyetli aktörlerin özel modelleri çalmasına olanak tanır ve esasen onlara geliştirme çabası olmadan değerli yapay zeka çözümlerine bir kısayol sağlar. Bu durum kuruluşlar için mali kayıplara yol açmanın yanı sıra önemli bir rekabet tehdidi de oluşturmaktadır.

Öte yandan çıkarım saldırıları, görünüşte zararsız sorgulardan hassas bilgiler çıkarmak için yapay zeka modelinin yanıtlarından yararlanır. Bu tür saldırılar gizliliği ve güvenliği tehlikeye atarak onları oldukça tehlikeli hale getiriyor. Yapay zekanın hassas verileri ayıklama yeteneği, kimlik hırsızlığı ve kurumsal casusluk gibi çeşitli kötü amaçlı faaliyetlere yol açabilir. Dolayısıyla bu saldırılar, geniş çaplı hasara neden olma ve hem kişisel hem de kurumsal güvenliği tehlikeye atma potansiyelleri nedeniyle özellikle endişe vericidir.

Analistler, bot yönetiminden AI/ML güvenlik araçlarına kadar AI modellerini korumak için bir dizi güvenlik ürününün ortaya çıkacağını öngörüyor. Bu tahmin hakkındaki düşünceleriniz neler ve öne çıkacağını öngördüğünüz başka siber güvenlik alanları var mı?

Bu makul bir tahmin. İleriye baktığımda, açıklanabilirliğin yükselişini öngörüyorum. Yapay zeka sistemleri daha karmaşık hale geldikçe, özellikle sağlık ve finans gibi kritik uygulamalarda kararlarını anlamak çok önemli hale geliyor. Yapay zeka modellerinin yorumlanabilirliğini artıran araçlar şeffaflık sağlayarak kuruluşların modelin bütünlüğünü etkileyebilecek olası önyargıları veya güvenlik açıklarını belirlemesine olanak tanır.

Ek olarak, işbirlikçi yapay zeka gelişiminin yaygınlaşmasıyla birlikte, birleşik öğrenme güvenliği hayati hale gelecektir. İşbirlikçi eğitim çalışmaları sırasında veri sızıntısını ve model manipülasyonunu önlemek için dağıtılmış öğrenme sürecinin güvenliğinin sağlanması gerekli olacaktır.